2013

Bob Ostertag et l'informatique musicale

Dans son texte « Why Computer Music Sucks » (= pourquoi la musique par ordinateur fait chier) le compositeur Bob Ostertag critique la musique par ordinateur (Computer Music) qui dans les milieux avant-gardes s'est embourbée dans des processus de programmations complexes au lieu de favoriser le résultat musical final audible et, où le résultat final médiocre de ces musiques ne justifie pas l'effort démesuré du travail d'élaboration de programmation. La programmation entrave-t-elle la composition de la musique ? Le résultat global est une uniformisation de la musique savante par ordinateur qui utilise les dernières nouveautés technologiques sophistiquées des traitements du timbre et de la composition, mais sans vraiment de résultats probants. L'exemple des 287 pièces soumises au jury d'Ars Electronica en 1996 où une seule sortait du lot par sa nouveauté de timbre était réalisée avec un vieux synthétiseur Buchla analogique des années 70. Aujourd'hui en 2013, on est au même point.

Il apparaît clairement aujourd'hui que des outils informatiques (chers et) sophistiqués ne font pas obligatoirement des musiques originales. Les espoirs d'élargissement des possibilités sonores pour la musique avec l'informatique ne se sont pas développés ni réalisés comme nombre de compositeurs l'escomptaient (Varèse pour ne citer que lui). Il existe une impasse qui ne peut être dépassée. Une impossibilité. Pourquoi ? La musique savante ne s'est cantonnée avec l'ordinateur que sur deux pôles majeurs : la composition algorithmique (automatique) et l'exploration extensive du timbre à travers différentes synthèses numériques basées majoritairement sur l'analyse de Fourier FFT = "Fast Fourier Transform" basé sur l'idéologie pythagoricienne (sauf pour Xenakis qui introduit la synthèse granulaire qui s'extrait de l'idéologie harmonique en série). Ce qui pour la musique reste relativement pauvre. Aussi les carrières institutionnelles ont prévalu sur la créativité. Les programmes pour la musique servent moins les compositeurs que la position sociale des programmeurs qui s'évertuent de garder leur place dans l'institution. Le dialogue avec certains compositeurs fut rompu au nom de cette résistance à la créativité.

L'informatique musicale uniformise la musique dans son langage binaire simpliste.

Au contraire, dans le domaine « populaire » malgré une imposante pression du marketing qui empêche l'émergence de musiques originales, des « bricoleurs » ont détourné l'outil informatique pour bidouiller leurs musiques principalement à base de séquences de sampling. Mais nous dit Bob Ostertag le sampling n'est pas l'informatique musicale. Le sampling s'empare des sons enregistrés de tout, aussi bien des sons de synthèse de l'ordinateur. Le sampling est contraire à l'esprit de la Computer Music (l'informatique musicale) : le sampling ne synthétise pas, il pioche et détourne. Dans ces productions musicales, l'ordinateur intervient plus dans le studio d'enregistrement comme magnétophone multipiste que dans la composition algorithmique ou la synthèse des sons. L'ordinateur a rendu le studio d'enregistrement des musiques « populaires » accessible à tous [2]. Le coût d'un multipiste est passé de « acquisition impossible » (il fallait louer le studio d'enregistrement) à « ordinateur personnel + interface audio (carte son) + logiciel multipiste » (Reaper est à 60€) et quelques micros, chez soi.

...

L'indisponibilité musicale des programmes destinés à la musique des institutions pour la musique :

(dû à leur coût, ou leur fonctionnalité, ou leur utilité, ou leur sonorité, ou leur durée de déchiffrage, ou leur obsolescence, etc.)

. L'application phare de la musique par ordinateur : Max (nommé ainsi en l'honneur de Max Matthews) de Miller Puckette conçu à l'IRCAM puis nommé Max/MSP (Ircam -vendu à> Opcode -vendu à> Cycling 74 de David Ziccarelli : logiciel payant) contre PureData (logiciel gratuit et open source) toujours de Miller Puckette (en réaction au vol de son programme).

. L'application phare du MIT : Csound de Barry Vercoe à la suite de Music V de Max Matthews (logiciel gratuit).

. Les applications de l'Institut de Recherche Coordination Acoustique Musique (IRCAM) : Chant, SVP puis AudioSculpt, Modalys, PatchWork puis OpenMusic, Spat, etc. : « L'utilisation de ces programmes et de sa documentation est strictement réservée aux membres des groupes d'utilisateurs de logiciels Ircam » (sic) : logiciels payants en location annuelle, dont la plupart sont devenus obsolètes.

. L'application du Groupe de Recherche Musicale (GRM) : GRM Tools (logiciel payant).

Première version 1.5 en "stand alone" sur Mac conçu pour l'interface audio Digidesign 442 avec carte NuBus : sonne.

Sa version VST pour PC : ne sonne pas.

. d'autres logiciels d'instituts pour la musique ? En fait, énormément et très peu qui se remarquent, d'où l'uniformisation de la sonorité informatique.Verdict : conception remarquée pour des résultats sonores (trop souvent) décevants.

...

.

2010-2014

Les logiciels sauvages (non institutionnels) pour la musique

Entre le logiciel commercial et le logiciel institutionnel, il existe une autre voie prise par des programmeurs indépendants qui s'essayent à l'exercice. Et cela donne des résultats parfois étonnant comme Paul's Extreme Sound Stretch ou Scala. Restent insuffisamment nombreux.

...

.

Applications pour nerd (de l'informatique pour l'informatique),

pas pour la musique ni le musicien

Le premier critère d'adhésion pour un outil (logiciel) musical audio est sa sonorité. C'est un critère non mesurable et inexorable : ça sonne ou pas : sa pérennité en dépend. Le second critère d'adhésion pour un outil (logiciel) musical est le plaisir de son utilisation. Ce second critère inclut ses accès (rapport travail logiciel / résultat musical), sa fonctionnalité, son originalité, son efficacité, etc. : son instrumentalité. Un logiciel de musique ne peut pas être un obstacle à la musique. Nous nous sommes toujours demandé pourquoi les programmes musicaux institutionnels sont en majorité inaccessibles dans l'immédiateté et ignorent même le sens de la musique ? Est-ce que le programmeur jalouse la place sociale du compositeur (qu'il envie pour quoi) ? L'informatique musicale a le complexe de la « prestation de service » dont elle veut se débarrasser en voulant prendre la place à la musique. Le programmeur a pris la place du compositeur en ignorant le sens de la musique. Les informaticiens de la musique veulent se sentir utiles, car au fond, ils savent que c'est une vaste blague (Gérard Assayag, communication personnelle). Toutes les collaborations sont restées timides ou infructueuses aux dépens de carrières fonctionnaires (de prestige ? ridicules). L'informatique reste un outil (pas un atelier comme l'avance J.C. Risset) et certainement pas encore un instrument de musique effectif pour le musicien qui ne se décolle pas de l'écran (un musicien fait de la musique -touché, vibre- pas de l'ordinateur en regardant un écran). L'informatique musicale est l'outil principal de la musique enregistrée (recording, mixing) et donc de l'industrie du disque (ou ce qui en reste), du jeu vidéo et du cinéma. En 33 années de recherches musicales en informatique, quels sont aujourd'hui les outils utiles qui restent au musicien ?

En 1968 John Chowning travaille à Stanford les Mouvements Sonores Virtuels qui jusqu'à ce jour reste indisponibles dans une application sur plate-forme PC, Mac ou Linux (?). Nous nous sommes toujours demandé pourquoi son programme de spatialisation ne fut jamais rendu disponible sur ordinateur personnel ? Il existe juste une publication de sa conférence de 1971 [3]. En 1977 apparaissent les premiers ordinateurs personnels avec Apple, Commodore et Atari. Puis en 1982 les ordinateurs compatibles PC (Personnal Computer) et en 1984 les Macintosh. Atari reste le seul ordinateur qui intégra une interface MIDI dans sa machine : très pratique pour le musicien qui n'existe plus aujourd'hui. Le « protocole » MIDI sort en 1983 avec le premier synthétiseur à Modulation de Fréquence, synthèse conçue par John Chowning dont il vendit la licence à Yamaha qui produisit le DX7 jusqu'au SY99 en 1996. Aujourd'hui cette synthèse n'a pas évolué et se retrouve dans des synthétiseurs virtuels particularisés avec le FM7 et 8 de Native Instruments. Tout comme la synthèse (très prometteuse) par modélisation qui aujourd'hui n'est utilisée que pour imiter (mal) des instruments déjà existants et dans ce cas le « sampling » fait mieux (quoique les Pianoteq est un début de réussite). Cela reste vrai aussi pour la synthèse granulaire. Ces 3 synthèses strictement numériques n'ont pas encore accédé à l'état d'instrument de musique, mais sont restées en l'état d'effets spéciaux pour le « sound designer » attaché à l'industrie du cinéma.

Les outils numériques destinés et qui servent à la musique ont plus été conçus par des anonymes indépendants que par le système institutionnel des centres de recherche ou le système commercial propriétaire. Je pense à Nasca Octavian Paul le Roumain qui a conçu un petit programme gratuit de time stretching particulièrement musical. Je pense à Anadi Martel le Québécois qui conçut en 1982 une machine de spatialisation des sons dans l'espace utilisant l'algorithme de Gerzon dans la diffusion quadriphonique : le SP1 (Spatial Sound Processor) puis le SSP200, aujourd'hui malheureusement introuvable. Beaucoup d'autres et peu ont élaboré des machines et des programmes pour la musique de façon artisanale et dont le commerce fut toujours un échec : le prix d'achat demandé était trop élevé pour le musicien (ils oublient que l'industrie du disque c'est effondrée et a complètement rejeté l'inventivité musicale), et la médiatisation de ces outils, difficile. Beaucoup de ces outils sont tombés dans l'oubli à cause de ce déséquilibre économique. Le musicien original d'aujourd'hui est pauvre et indépendant : il n'intègre plus l'industrie du disque et le système économique du « divertissement » [4].

Le cas des nerds, les fonctionnaires et la musique

Programmes de nerds

Contrairement à un instrument de musique, les programmes informatiques musicaux nerds ont la fâcheuse tendance d'obstruer le lien direct à la musique : le temps réel (sic). Ces programmes sont en général proposés par des universités et des instituts, et à la première approche ne semblent pas destinés à réaliser de la musique (en temps réel), mais plutôt des programmes dans le programme. Ce qui pour la musique est inutile ou trop laborieux pour être des outils destinés à la création musicale (déjà bien chargée par la théorie, la technique et l'organisation orchestrale). Aussi, la capacité de donner des programmes inachevés dont certaines fonctions du programme ne fonctionnent pas ou sont bugués (contradictions qui plantent le programme), est une tendance des programmes nerds, voire des systèmes d'exploitation informatiques : il n'existe toujours pas (25 ans après le 1er Atari dédié) d'OS adapté à la musique ! Au lieu de ça, est répendu une tendance fâcheuse et inutile à faire rêver à des choses inaccessibles pourtant faisables (dont mes 1eres expériences furent non-réalisées à l'IRCAM).

Les mêmes :

. Max/MSP (payant)

. Pure Data (gratuit)

Du même auteur Miller Puckette dont l'un, lui a été volé et vendu et l'autre, une réaction de sa propre initiative au premier vol.

... Pourtant Miller joue du violon...

. CSound (gratuit) de Barry Vercoe du MIT

. programmes de l'IRCAM (payants, Mac exclusivement)

. SuperCollinder (gratuit) de James McCartney

pour les principaux, ensuite ?

Jusqu'aux programmeurs qui vendent des patchs des programmes gratuits ci-dessus !« Un synthétiseur analogique est déjà + musical et a l'avantage de ne pas avoir d'écran. »

Un programme parmi kyrielle (reçu en juin 2014)

Des nerds de la communauté NIME

'the Open Source release of PESI extended system developed at SOPI research group (Aalto University)'

Eh bien oui ! une application audio pour téléphone mobile : Aalto c'est en Finlande, et en Finlande il y qui ? Nokia bien sûr ! L'utilisation de Pure Data donne à ce projet la possibilité de rejoindre le monde international des nerds de l'informatique musicale ! suis-je « mauvaise langue » ? Mais bon, depuis que je reçois les infos de la communauté NIME (community@nime.org) : cela depuis + de 15 ans, qui est un regroupement censé créer des interfaces musicien-ordinateur (il est possible que je n'ai rien compris) : mais vraiment, jamais rien de pratique pour la musique (la créer la jouer) n'est sorti de ces universités et institutions, rien : il n'y a pas pire que des nerds universitaires qui donnent de faux espoirs à la musique (bricolant dans leurs coins des trucs inutiles, voire insensés et convaincus de leur nécessité pour les autres), semble-t-il ! Savent-ils qu'un système algorithmique restera toujours systématique alors que la musique n'est pas un mécanisme et ne le sera jamais. Le problème du nerd est qu'il magnifie l'insignifiance, il se réjouit + du fonctionnement que du résultat (un enfant qui joue). Ce qui explique en partie l'invasion planétaire de musiques médiocres qui étouffent les autres. Ça les fait marrer ! Tant que ça reste futile et annihile la jouissance profonde d'une musique sublime dont ils se moquent (irréalisable pour eux). Tout ça, ça ressemble plus à du dénigrement (issu de frustrations) + qu'à de la création originale.

Anecdote

Le domaine du bricolage instrumental est envahi par la tendance geek DIY (fait le toi-même), plein d'objets électroniques, les fils à l'air qui font pouet-pouet, tin-tin et autres sonorités signalétiques qui leur suffit, pour dire qu'ils font de la musique. Au STEIM à Amsterdam en 2011, j'en ai rencontré quelques-uns. Son directeur dans l'urgence m'a demandé de venir avec ma Lampe Archisonic pour montrer qu'il y a autre chose que : des sons de buzz (l'éclair ?) LoFi, qu'on peut réaliser avec des objets non destinés à la musique LowCost traités en instruments de musique. Je me suis efforcé de faire sonner la lampe d'architecte (1980-2007 devenue Archisonique pour la musique) en développant des accès de jeu instrumental, donnant la possibilité à une interprétation la + large et la + dense possible pour le musicien : c'est tout et ça sonne....

.

2007

La reproduction numérique du son

Le système de la conversion numérique du son avec le principe de Fourier (FFT pour Fast Fourier Transform) favorise les partiels (les ondes sinususoïdales constituantes du son) graves plus que les partiels aigus. En effet, plus les sons sont aigus et plus l'échantillonnage de leurs ondes est bas et inversement. Quand la fréquence d'échantillonnage est fixée à 44.1 kHz (valeur pour le CD audio), le son est tranché en 44 100 tranches par seconde (pour le cinéma 24 images/seconde). Mais suivant la position fréquentielle de la fondamentale du son échantillonné, le tranchage ne sera pas similaire pour un son grave ou pour un son aigu. Car leur longueur d'onde est différente : plus large pour un son grave et plus courte pour un son aigu, ce qui donnera un échantillonnage moindre pour les sons aigus. Exemple, un son aigu dont la fondamentale se situe à 8 kHz (le champ audible se situe entre 30 Hz et 16 kHz) sera tranché 44 100 / 8 000 = 5,5125 qui en conséquence donnera à l'onde pour sa révolution orbitale (son tour complet sur elle-même) que quelques échantillons : une onde aigüe aura 5 échantillons (de 5 valeurs sur 65 536 pour un codage en 16 bits pour la valeur d"amplitude de l'échantillon) en moyenne pour se faire reconnaître (1 échantillon isolé d'onde donne un clic audio). Ce qui paraît insuffisant à l'audition. Ou uniquement à bas volume d'écoute, car notre cerveau compense en recomposant le manque d'information de ce qui est perçu du son. Mais une fois dépassé le niveau critique de l'amplitude d'écoute proportionnée, les quelques bits de l'onde génèreront un bruit numérique bien connu où le son d'origine est complètement dénaturé [5].

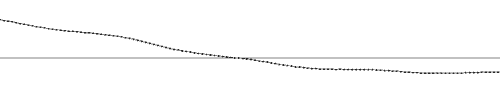

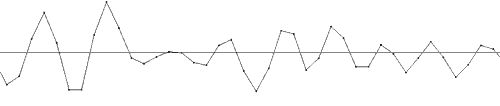

amplitude en ordonnée et temps en abscisse :

chaque point correspond à un échantillon (une tranche avec sa valeur d'amplitude en bit) :

au-dessus échantillonnage d'un son grave et en-dessous d'un son aigu

Le système d'échantillonnage numérique de la musique enregistrée favorise une certaine musique qui se délecte dans les basses, puisqu'elle lui est appropriée. La basse dans la musique occidentale (le fondamental dans un spectre sonore harmonique théorisé d'abord par Pythagore puis par Fourier) est le pilier à partir duquel se construit l'harmonie (l'art des accords) : la musique occidentale ne construit pas ses accords de sons, à partir des sons aigus. Ses détracteurs diront que c'est irrationnel. La synthèse additive vient du même principe harmonique. Aussi, les tweeters dans une enceinte acoustique ont une puissance bien moindre que le haut-parleur grave dans une proportion d'1/6e à peu près. Le système d'écoute de la musique occidentale c'est adapté à notre croyance culturelle, de ce que l'on projette, croire ce qu'est la musique et comment elle se décompose quantitativement. Une approche unique que les autres civilisations n'ont pas eu la chance de développer dans une autre technologie culturelle qui aurait pu nous montrer la particularité de la perception de notre culture occidentale.

La recherche de basses dans la musique occidentale correspond à un désir de réconfort, de bien être (comment en pourrait-il être autrement ?). Ce réconfort est recherché dans la mémoire profonde de soi du foetus qui perçoit des sons sourds (je ne vois pas ailleurs où la mémoire pourrait piocher son réconfort). Le son sourd enrobe le corps de vibrations lentes qui nous réconfortent, au contraire des sons aigus qui « électrisent » la tête. Les basses se ressentent au niveau du ventre et de la cage thoracique alors que les sons aigus sont ressentis par la boite crânienne (aussi, aigu signifie douloureux et grave, dramatique). La particularité de la musique occidentale à favoriser les sons graves (jusqu'à utiliser des sonorisations diffusant les extrêmes graves à forte puissance) dont chacun se réjouit se déduit de cette recherche de confort à travers la musique. Cela montre que la civilisation occidentale est fondée sur la terreur de l'inconfort. Et que toute son énergie, sa culture vont dans ce sens, à s'extraire de l'inconfort. Mais quelle est cette terreur indicible inconfortable que notre civilisation occidentale cultive ? C'est l'hostilité donnée « innée » à la vie (qu'elle n'a pas).

...

.

1990-2020

Mao et la composition musicale

la musique assisté par l'ordonnateur Mao ?Sommes-nous tous handicapés ?

le fantasme du cyborg du super-héro montre que oui.Avec l'informatique musicale, la MAO : musique assistée par ordinateur (sic), les compositeurs sont devenus des « sound designers » pour le cinéma, fabricant des sons d'artifice (comme les feux) pour éblouir (aveugler ? pour être illuminé et recevoir l'illumination ?) les spectateurs (impressive, being impressed). La partie formelle de la composition étant moins accessible aux utilisateurs puisqu'elle demande un travail autrement plus prenant que la synthèse numérique de sons. La composition musicale demande de l'inventivité formelle qui ne se réduit pas aux dosages de paramètres, ni à la disposition de « blocs » de sons dans la durée d'un séquenceur. La sonorité des sons pour l'instant suffit à l'audition de l'auditeur, mais ne suffit pas à la composition musicale. La distinction entre : une suite de sons et une composition musicale est évidente et incomparable : l'une sonne le son des sons et l'autre émeut. Le degré de prédictibilité des sons même inouïs sans l'être amène l'ennui ou renforce le stéréotype. Composition et stéréotype sont des termes d'imprimerie. L'ordinateur est un mécanisme et ne peut s'extraire de cette prévisibilité : la machine a été conçue avec ça et pour ça : être pré-visible. La composition musicale qui déjoue la prévisibilité est à l'opposé de cette conception de prédictibilité mécanique. L'esprit combinatoire de la sérialisation ne suffit pas à la composition (surtout avec une seule unique horloge). C'est-à-dire, combiner un nombre fini d'objets sonores graphiques (fichiers) dans différentes positions temporelles ne suffit pas à la composition de la musique.

Mémoires/oublis en action

L'intérêt majeur de la composition musicale est le jeu entre autres avec les mémoires. C'est à partir de mémoires que la musique se forme. Les mémoires sont multiples aux qualités différentes et s'incluent dans une temporalité, autrement dit dans une cosmogonie d'un temps imaginé (voir les différentes conceptions temporelles des différentes cultures : linéaire occidentale, circulaire orientale, instantanée africaine, etc.). La mémoire ne réside pas uniquement dans le passé (dans la conception linéaire du temps occidental : passé, présent, futur), mais dans toutes les temporalités. Le futur est une projection de la mémoire, un possible imaginé. La composition musicale réside dans ces jeux des temps qu'une horloge mécanique réduit à des horaires.

...

.

2012

Quel est l'apport de l'informatique à la musique ?

Apport technologique (de l'outil)

1. A remplacé le magnétophone jusqu'au magnétophone multipiste au nombre de pistes quasiment infini qui dépend de la puissance du processeur et du nombre d'entrées dans « la carte son » ou interface audio analogique - digitale. A remplacé les consoles de mixage studio. A remplacé les effets studio (filtres, compresseurs, harmoniseurs, etc., et a créé d'autres outils comme « l'autotune » qui réajuste une voix dans la tonalité en temps presque réel, etc.).

2. La possibilité d'utiliser l'ordinateur comme un synthétiseur (avec de multiples connexions possibles entre les générateurs de sons et les traitements du son) et facilement transportable depuis la création des laptops.

3. un grand nombre d'instruments virtuels : synthétiseurs, traitements, samplers, etc., disponibles (dans une seule boite). Dont la majorité copie les instruments électroniques et acoustiques passés.

4. Un montage audio au millième de seconde : à l'échantillon près.

5. Des synthèses impossibles autrement : la synthèse granulaire, la synthèse par modélisation (trop exploitée à imiter les instruments déjà existants), la synthèse par modulation de fréquences (abandonnée).

6. L'automation généralisée à tous les paramètres ou presque.Ces 6 avantages font de l'ordinateur, un studio d'enregistrement transportable (sans les micros, les préamplis, les amplificateurs et les enceintes). Utilisable comme instrument de musique (presque en temps réel : latence de 7ms avec un buffer à 256 samples) sans le clavier (piano) ni l'interface MIDI ? Chose étrange, les accès de contrôle comme instrument de musique restent rudimentaires, malgré une trentaine d'années de recherche : gant avec détecteur de positions et mouvements, manettes 3D, potentiomètre 1D et 2D, etc., boutons et clavier restent comme pour les synthétiseurs analogiques du XXe siècle : le type de contrôle encore le plus répandu. Le protocole MIDI 7 bit est toujours là, 29 ans après sa création (1983). C'est dans les accès au jeu vidéo et industrie du divertissement que la musique pioche et adapte ses outils à la musique : voir récemment les manettes sans fil Wii (sans câble, ça fait plus magique) et tablette écran touchpad avec des curseurs lumineux. Bien qu'avec le DX7 en 1983, il était muni d'un contrôleur par le souffle en protocole MIDI qui n'a pas évolué depuis (seul le « saxophone » MIDI Akaï l'utilise, mais les saxophonistes comme les guitaristes préfère l'instrument acoustique). L'interactivité tend à s'affiner, mais demande une programmation assez lourde. La poussée de l'utilisation du programme Max dans les années 90 ne donne malheureusement que des résultats attendus. Il y a quelques années, Gérard Assayag a développé OMax un programme créant un musicien artificiel, reste plus prometteur (?) que les simples opérations logiques de l'interactivité usuelle : « si ça, alors ça ». Mais cette possibilité de l'informatique musicale reste encore rudimentaire.

Personnellement l'ordinateur me permet en ce moment :

1. d'enregistrer et de synthétiser des sons pour créer un instrument de musique virtuel (avec le sampler)

2. de former des orchestres virtuels (avec n'importe quel objet sonore) spatialisés dans l'espace 3D (rassemblé dans le sampler)

3. d'affecter les échelles nonoctaviantes découvertes à chaque instrument permettant une harmonie autre que celle des 12 1/2 tons divisant l'octave.

4. de disposer cet orchestre dans le multipiste en générant des rythmiques injouables ou difficilement jouables par le musicien humain (dextérité musculaire impossible).

5. de trancher la composition finalisée pour la jouer en concert comme plusieurs « momente form » superposables ou la composition elle-même devient un instrument de musique 3D jouée avec un sampler avec un clavier MIDI dont la musique est recomposée pendant le concert, jouée en temps réel (sans écran).

6. composer et mixer la musique de film (avec dialogues et bruitages) sans passer par le studio, puisque l'ordinateur fait office de studio.Le tout sans musiciens : je peux tout faire par moi-même : du jeu instrumental jusqu'à l'album mixé et masterisé.

- Mais cela n'isole-t-il pas ?

- n'est-ce pas contraire à l'esprit de la musique ?.

1990-2020

Le son numérique reste le son numérique : douçâtre (avec des clics).

La sonorité attachée aux machines enregistreuses est indéniable. La sonorité des outils et des instruments de musique dépend de 2 choses : de la culture et de la tendance. Notre culture occidentale favorise dans sa musique les basses (autour de 100Hz) qui demandent une grande énergie (puissance) pour être produites (contrairement à pratiquement toutes les autres musiques de la planète qui se reposent sur la partie sensible de l'audition localisée autour de 3kHz). Cette culture des basses fonde l'harmonie-tonale avec un son de base dit fondamental sur lequel s'accrochent les harmoniques : cette conception a formé le chant (sur les harmoniques) et l'accompagnement (la fondamentale pour la tonalité du chant : basse continue). Avec l'arrivée de l'énergie électrique et du haut-parleur, les basses n'arrêtent pas de s'amplifier et de s'approfondir. Notre tendance est d'obtenir « un son propre » (pas sale) à l'enregistrement et à la diffusion. Les magnétophones à bande de l'ère analogique produisaient du souffle que l'ère numérique ne produit plus, à la place, il produit des clics (échantillonnage oblige). Le « denoiseur » (le bruit en anglais est une dispute tapageuse en français, du latin « nausea » = mal de mer) est le premier effet attaché à l'informatique audio : en revanche, il produit un artefact qui ressemble à de l'eau : le son dans l'air (souffle) passe dans l'eau (glouglou). La production de grande puissance sonore pour entendre les basses a réégalisé le champ audible grave-medium-aigu (le fameux « loudness » des « chaînes Hifi » des années 70 du XXe siècle) : pour éviter l'agression sonore, il fallait baisser les médiums et les médiums aigus, là où tout le « grain du son » (sa texture) réside : la sonorité des équipements numériques est devenue douçâtre par excès de puissance et de « pureté » (retirer le sale, mais qu'est-ce qui est sale ?). La sonorité de l'Occident est directement liée à son désir de domination et de purification (loin du dégueu du dégoûté), base cosmogonique de notre civilisation. Notre génération de musiciens a réintroduit et généralisé « le sale » dans la musique : processus indispensable pour le rééquilibre mental de nos sociétés. Avec les équipements numériques, on se retrouve avec la standardisation, l'homogénéisation, l'uniformisation, la « normalisation » de la sonorité instaurée par l'idéologie des circuits électroniques des interfaces audio qui transforment les ondes électrifiées en nombres. La tendance audio est d'impressionner par les basses : le film Tremblement de Terre a introduit les infrabasses dans les cinémas en 1974 je crois qui aujourd'hui est banalisé avec les dispositifs THX ou Dolby Surround (avec l'infrabasse séparée dans un coin). Le projet numérique a renforcé la croyance de l'objet sonore : le son comme un objet qu'on dispose (le vibrant capturé, tout comme son signe écrit qui le re-présente) et non un agrégat vibrant en état changeant. Le fichier audio accentue cette croyance. Nous pouvons dire que l'esprit métrique réalise son grand projet dans le numérique, pour le contrôle (le gouvernement politique) de l'humanité avec des caractéristiques quantifiables et donc chiffrables est une illusion de domination. C'est une vision, une croyance et une culture qui a repoussé la musique à de l'ambiance sonore : le manque de médium qui rend toute vibration intelligible, désagréable agréable ou supportable, même à très grande puissance. L'intolérance développée utilisant des mots comme « dissonant » et « bruit » dans la conception même dépassée de la musique a obligé les créateurs de synthétiseurs « d'adoucir » la sonorité de leur machine : le bruit acceptable de l'audio chiffré. (le sampler kontakt sonne douçâtre). [7]

Dans l'idée de départ, le « son numérique » (les machines enregistreuses (comptables) et diffuseures) a été réalisé pour la « musique classique » : oui, pas pour la musique « contemporaine ». L'étendue dynamique du disque vinyle est de 40 dB qui avec le disque compact (12 cm au lieu de 33 avec 60 minutes au lieu de 2 x 20), le CD est passé à 90 dB. De l'inaudible à la douleur nous entendons dans une étendue dynamique de 120 dB environ qui dépend de la fréquence (la dynamique d'un son grave est moindre qu'un son médium aigu) et du contexte et de la croyance. Cette « avancée technologique » a donné au son une « identité + remarquable » (loudness pour + de basse et d'aigu (= moins de médium) et + de puissance que le mot anglais désigne). Ça a impressionné. Le revers de cette « avancée technologique » est le manque de présence du sonore dans la chaîne électroacoustique ; manque de présence : la sensation de fortissimo (fort) et pianissimo (faible) ne dépend pas uniquement de l'amplitude et de son champ dynamique. Pour refaire revenir la sonorité de la musique devant, là avec nous et non en fond sonore douçâtre, il n'y a pas d'autres moyens que d'abuser de compresseurs et de filtres pour rendre la présence retirée.

Le format d'archivage (archie = dominant)

de la musique enregistrée semble se fixer sur le disque dur même : en 30 ans nous sommes passé du vinyle au CD au mp3 et FLAC pour l'écoute « grand public ». Les cartes audio sont passées du NuBus au PCI généralisé pour toutes les plates-formes jusqu'au PCMCIA des portable et USB ou FireWire. Les disques durs à connectiques SCSI (Apple] de IDE au SATA (PC & Apple) plus la connectique externe Firewire (Apple puis PC) et USB (Apple et PC). Disquette 750Ko et 1.4Mo et « grosse disquette » 80 Mo sont obsolètes, le CD de données 700 Mo ou le DVD 4,5 Go deviennent obsolètes (les données « se perdent » rapidement) remplacés par USB Flash Memory ou clé USB qui passe de disque dur en disque dur, en fait remplacés par le disque dur lui-même. Les enregistrements studio sont passés des bandes magnétiques du magnétophone aux bandes numérique DAT (Digital Audio Tape) aux disques durs. Les formats PCM audio non compressés principaux heureusement n'ont pas changé AIFF pour Apple et Waves pour PC (bien que PC lit et enregistre en AIFF et que Apple peut enregistrer et lire en WAV), mais cela dépend des logiciels si les formats sont implantés ou non. Tout cela en à peine 30 ans.Programmes-conteneurs ouverts

Il semble qu'à partir des années 2005, certaines équipes de programmeurs se soucient plus de faire évoluer leurs programmes informatiques musicaux vers l'interactivité de l'instrument de musique. Il existe un sampler (kontakt) et un looper (live) qui en ce moment ont la cote des musiciens-compositeurs. Ces programmes-conteneurs ont eu la bonne idée d'ouvrir leur programme aux musiciens programmeurs qui proposent des sous-programmes (avec script abordable) pour personnaliser leur instrument. Un programme fermé n'évolue pas et meurt par inutilité. Bien que Miller Puckette ait pris cette direction avec Max puis avec PureData, mais leur programmation demande un trop « gros effort » (de temps en +) supplémentaire que les compositeurs-musiciens déjà surchargés ne sont pas prêts à donner. Ce sont encore des programmes pour : « computer geek » pas pour musicien : le temps de la programmation ne peu pas dépasser le temps de la composition.

.

L'informatique musicale et le cinéma

L'informatique audio est véritablement conçue pour le cinéma (et le home cinéma) qui fournit toutes les standardisations comme le 5.1, inutile à la musique. Tout dans l'informatique multimédia est conçu pour joindre « le son à l'image ». Même les « jeux interactifs » initiés par un programme comme « Director » [6] n'ont pas résisté au règne du cinéma. La musique a le troisième rôle après l'image et la parole. Tout le dispositif de l'informatique musicale est conçu pour ce second rôle, de la musique dans le cinéma : accompagner l'image, la rendre « réaliste » par des artifices. Au cinéma plus un son est éloigné de la réalité plus il paraitra ou sera considéré comme vraisemblable par la « preuve » de l'image. Le bruitage ancien (foley et sound effect) intégré dans le « sound design » (esthétique utilitaire du son), ne copie pas « les sons de la nature », mais les recrée par numérisation. L'architecture même, de l'analyse de l'onde audible par de l'algorithme majeur FFT (fast Fourier transform) qui décompose une « vision » particulière de l'audible en simples oscillations (sinus), qui est le nommé « son », convient au second plan de la musique au cinéma. Le registre médium creusé de la musique laisse la place à la voix parlée. La musique numérique [7] pour le cinéma rejoint le « sound design » dans l'entremêlement de son intention : du « stéréotype utilitaire » de la représentation du pouvoir de la puissance politique de l'Occident américain.

...

ce texte est en anglais, car il concerne une + large communauté que celle francophone :

la globalisation planétaire informatique est une intension de culture anglophoneThe End of Computer Music?

Something is deeply wrong with computer music

the unfinished possible...

The purpose of the nerd (a person educated as intellectual working in an office who does not know what to do with her/his life) is to never finish the work (to keep her/his job). Being in state of permanent updating of what is unfinished. But sold as it. Yes! Users are paying to use unfinished tools. A tool that creates problems in opposition of a tool to resolve problems. Let us make a comparison with food: imagine to be obliged to buy unfinished fruits and vegetables being unriped, eating them to not die of hunger, waiting being seek for the next upgrade? Until today, we are waiting almost 30 years for food to be riped. Something is wrong, isn't it?

With musical instrument, there is no upgrades or updates. The tool must be achieved, and useful to sound, and to sound various and deep. To be performed to create music. In opposition: a computer is always in a state of being upgraded and the programs updated stay never finished. Why? To keep alive the computer industry, to keep the nerd's activity, with no sense of life. Which has nothing to do with music, but with money.

Music with unfinished musical instrument does not work. Or works with unneeded unnecessary complications of the unfinished instrument. And computer music does not work without unnecessary complications: listenable in its mechanical digital synthesis sound. As others, musical programs are sold unfinished to wait and pay the update of what could be done, but never really do.

This conception of human activity, sustain the "paying society", a corruption, doing something else to do what you want to do, a society where you have to pay to be aloud to live (decently): a slavery society conducted by slaves sustain by salary: a pension any human deserves in "paying society".

But the computer and programs industry are in contradiction with the Internet network, which its foundation is: free sharing of knowledge between human beings: its first purpose now corrupted by property and payment making knowledge exchange not free or biased (by people convinced they know better than others). This huge amount of free corrupted knowledge in one hand and knowledge to be payed in second hand is the show of, of our believes which makes think we are intelligent: are we? to produce and maintain so much archives, and garbage by fear of death? This book will end with my death (in few years). Dead, I will not pay any more the host to aloud my web site public. My thoughts will be eaten and digest by others, and used or not to try to make human species less stupid to put itself and other living beings in danger (in domination by loosing selfgoverment).

But to access the network you have to pay a provider (+ the upgraded hardware equipment) which is in contradiction with the original free will being connected. But since the beginning we are connected electronically for what? Since the beginning of Internet my major activity is to send and receive emails: letters. Instantaneous videophone does not work yet to have non interrupted conversation, and people feel uncomfortable being seen in privacy. This technology is only useful for people far away from each other (same as telephone). Friends and family around, we do not need communication technology.

Is it useful to speak about the 2 abusive companies monopoly? At the next "global" starvation, they will be executed. By people supporting buying using their operating system and computers. Since the free operating system Linux in 1993, it does not exist free adapted computers to run it: means Linux as all others are supported the OS duopoly expenses. It never exists any OS for music.

Computer industry is in contradiction with music. Music share for free the sonic mankind gestures active being alive. Computer (with music) industry does not. The unfinished tools keep the computer industry profit real. From 1990s I bought 8 computers, 10 screens, 9 modems, 6 MIDI keyboards, scanners, tablets, printers, and too many softwares to update (forced by obsolescence) all garbage, since 1979 I have my same guitar. The amount of sold useless computer product goes beyond what was expected. Computer became the main tool of human activity and garbage. Everybody nowadays face a screen. I am writing this text with a computer I will publish with the an other connected computer in the Internet network in my website for you to read it, copy it, transform it. Trapped.

The permanent payment to upgrade to update what you already paid, and will pay again to keep it by paying the next upgrade update is a form of voluntary slavery which are exhausted and poisoned the unique and vital human resources of the Earth: water and food. Since the 90s of XX century, the amount of useless computers and peripherals garbage of electronic unfinished tools is absolutely huge compare to resources balance (what one needs as materials to do it). Useless electronic equipment (like cars and other) are stored in Africa (and India), where are living the most unrespected human being on Earth, in gigantic garbage storage where the pollution and illness of the worker are ignored by the international "well thinking" UNcommunity of richest countries users. The money benefit are so colossal that no information are communicate about this human scorn. Using a disposable computer (where the summit is the "laptop" defeated by the "iPad" and other "cellphone-computer-game-camera-walkman-tv" unrefurbishable because the updated programs ask for more powerful machine you need to buy if you want to use the updated software) contribute to small acts of Earth death multiplied by billion of users = killers. An irresponsible act to put our children in misery. The next generation will live starving in our garbages of useless electronic equipment which will collapse the network becoming secondary, and unnecessary. The utopia (the pipe dream) of unlimited cybernetics is living its beginning of its end, it's done: the consequences of brain and body pollution by planetary colossal garbage had started the misery of all species. By scorn.

Calculators has to restart an healthy proposal where nobody can take the power to slave anybody and to kill other species to get raw materials: plastic comes from petrol, and metal, gold, lithium, copper, etc., from mines. The series of wars in Afghanistan is to control their rich mines, nothing else. People being nerds will not die by making achieved programs tools to be full used. In contrary, it will stop the economical hegemony which kill our planet and ourselves being dependent to stay alive.

Computer's sounds sound as computer is what nobody expected. At the beginning. A series of clicks. Computer is a tool for (nowadays) film, a tool to record, to edit, to add effects, but not to play music. Its time is not real, its calculations are too simple. Bio+metrics does not work.

A musical instrument with age become better, a computer with age become obsolete. The amount of electronic equipment I acquired and paid, and clicks since 1990 is incomparable to what a musical instrument can give. One takes, the another gives. The computer industry (and all industry in general) is the perfect tool for an economic hegemonic dictatorship as we are living: a perfect tool to destroy our vital resources with the strong false belief of permanent abundance: which is not the state of eternal happiness and enjoyment.

The worst is: everybody knows, what I just say.

to make this text more understandable, some correction to suggest

Next episode: how to leave our stupidity?

2017

BILAN

En fait, ne suis-je pas déçu par ce que l'informatique n'apporte pas à la musique ?

01. jamais rien ne fonctionne comme on le conçoit

02. il y a toujours des pannes de fonctionnement

03. une configuration musicale intéressante plante la machine

04. il y a toujours des problèmes qui font que ça ne fonctionne pas

05. le temps passé à régler les problèmes est supérieur à la réalisation de la musique

06. les systèmes d'exploitation ne sont pas adaptés à la musique, mais à piéger le client

07. pour jouir d'une sonorité adéquate, il faut un équipement de sonorisation lourd

08. la dépense est sans fin

09. les logiciels ne sont jamais finis

10. la sonorité est homogénéisée et uniformisée (à revivifier obligatoirement en sortie d'interface avec de l'équipement analogique « vintage »)

11. l'assistance informatique renvoie à l'incompétence sans informatique ? oui

...

Ce que peu de monde sait, est pourquoi certains synthétiseurs et amplis analogiques sonnent (rien à voir avec les lampes) : c'est parce que leurs circuits électroniques assemblés sont illogiques (et les composants électroniques généreux). Mais ni l'illogisme ni le paradoxe n'est l'apanage de l'informatique, dans le cas contraire l'ordinateur ne fonctionnerait pas : la raison qui fait que ça ne sonne pas, réside là.

Comment sortir du piège ?

1. de l' « extension (mécaniques) des possibilités pour la création musicale »

2. du son numérique homogénéisé et uniformisé

3. de la standardisation de la musique

(par des logiciels qui ne tiennent pas compte des besoins réels de la musique qui fondamentalement depuis 30 ans n'évoluent pas)

4. de l'activité ordinateur bureau qui a englobé les autres

5. de perdre son temps à des tracasseries supplémentaires (à reajuster des systèmes inadaptés)

6. de ne plus avoir les yeux douloureux et aveuglés après des heures obligées de travail

7. de ne plus alimenter les poubelles de matériels électroniques obsolètes

8. de ne plus être accroc

9. du long travail effacé par plantage et mort de disques durs

...

Implications

1. J.-C. Risset et tous les autres nerds perdent leur boulot et se retrouvent au chômage (la duperie a assez duré)

2. la « computer music » prend la place qu'elle aurait dû avoir depuis le début : un instrument comme un autre

3. l'utopie du monde automatisé et globalisé CYBERNETIQUE gouvernant les humains est révolue

4. condamner les milliardaires de l'informatique (et tous les autres) à réparer les dégâts qu'ils ont commis

A. ofrrir le contexte de déconditionner nos enfants en leur rendant leur liberté (nous c'est trop tard)

au monde électronique futile illusoire dangereux et bêtifiant

en changeant fondamentalement notre régime de société d'industrialisation de la soumission, du servage et de la misère :

0. abolition du pouvoir politique, financier, médical, judiciaire, policier, fonctionnaire, etc., et toute activité nuisible à soi et aux autres

0 => 1. abolition de la hiérarchie

0 => 2. abolition de l'autorité

0 => 3. abolition de l'obéissance

0 => 4. abolition de la menace institutionnelle

0 => 5. abolition de la ségrégation, de la discrimination et de la persécution

6. dénormalisation de l'attitude attendu de l'être humain en société = développer son intelligence au lieu de la contrarier

7. abolition de l'esclavage (quel qu'il soit : économique, politique (de la guerre) ou social) et de son contexte : la domination

8. abolition du péage et de la carotte du salariat et instauration de la gratuité sans condition pour tous les humains bien sûr

9. recomprendre le sens fondamental de la liberté pour la vivre et développer son intelligence pour le bénéfice de l'humanité

10. celles et ceux tous responsables qui commettent des dégâts, réparent leurs dégâts : reresponsabilisation de ses actes envers les autres

...

B. résoudre le problème de la poubelle électronique planétaire et le reste qui nous empoisonne et les autres habitants la planète

...

5. réaliser une machine calculante suffisante à l'usage : sans la carotte de l' « upgrade » (clone de l'idéologie économique du « toujours + »)

(beaucoup trop de gens possèdent des machines trop puissantes pour l'usage qu'elles en font)

6. réaliser un système d'exploitation qui n'exploite pas l'usager (est-ce possible ? voir l'échec de Linux)

7. l'ordinateur est un calculateur visuillusionant pour humains qui s'ennuient : maintenant nous le savons.

...Et il s'utilise en audio pour ce qu'il est : un magnétophone

(amélioré ?).